85% operatorów modernizujących swoje data center koncentruje się na usprawnieniach, które podnoszą wydajność i zapewniają zgodność z aktualnymi przepisami, pokazało badanie Kingston. Wysokie miejsce zajmują również aspekty związane z rozwojem usług (75%), bezpieczeństwem (70%) i skalowalnością (70%). Wyzwaniem są przede wszystkim rosnące ceny energii, brak wykwalifikowanej kadry i regulacje dotyczące cyberbezpieczeństwa, takie jak NIS2.

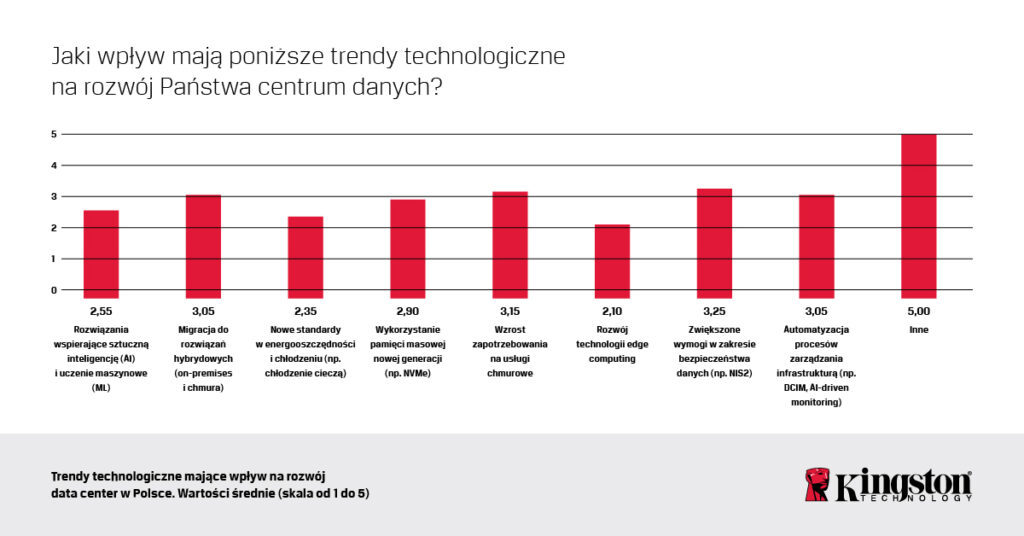

Ankietowani zostali poproszeni o przyznanie oceny ważności (w skali od 1 do 5) różnym kryteriom związanym z działalnością centrów danych oraz rozwiązań, w które inwestują lub są skłonni zainwestować. Za najważniejsze (średnio 3,25) uznano kwestie dotyczące bezpieczeństwa przetwarzanych danych oraz związane z tym rosnące wymogi prawne. Duży wpływ na działalność obiektów data center w Polsce ma także rosnące zapotrzebowanie na chmurę (3,15). Popularność zyskują również rozwiązania hybrydowe, łączące zasoby wdrażane lokalnie oraz w chmurze (3,05), a także automatyzacja procesów zarządzania infrastrukturą centrów danych (3,05).

Z badania Kingston wynika, że 95% badanych modernizuje swoje rozwiązania w miarę bieżących potrzeb, natomiast 90% kieruje się rozwojem technologii IT jako kluczowym czynnikiem inwestycyjnym.

Operatorzy data center wybierają dwa główne podejścia przy modernizacji infrastruktury IT w centrach danych:

- selektywne unowocześnianie kluczowych komponentów (np. pamięci RAM, dysków, systemów chłodzenia),

- planowe inwestycje o szerszym zasięgu, dostosowane do długoterminowych potrzeb.

Bezpieczeństwo przede wszystkim

Wśród priorytetów inwestycyjnych właścicieli i operatorów centrów danych zdecydowanie dominują kwestie bezpieczeństwa przetwarzanych danych i zgodności z przepisami – to one uzyskały najwyższą średnią ocenę (3,25 na 5). Coraz większe znaczenie mają też rozwiązania chmurowe (3,15) oraz automatyzacja i infrastruktura hybrydowa (po 3,05).

Koszty energii i brak rąk do pracy

Wśród wyzwań w zapewnianiu stabilnego działania centrów danych na pierwszym miejscu ankietowani wymieniali rosnące ceny energii (80%) oraz koszty modernizowania infrastruktury (70%). Ważnym aspektem są również wprowadzane przepisy związane z cyberbezpieczeństwem, takie jak dyrektywa NIS 2 czy DORA (60%), którym centra danych muszą sprostać. W mniejszym stopniu wskazywane były braki kadrowe (45%), problemy z wydajnością sprzętu (20%) oraz łańcuchami dostaw (20%). Rosnące koszty energii elektrycznej znacząco wpływają na opłacalność działalności centrów danych, zmuszając je do poszukiwania bardziej wydajnych rozwiązań w zakresie zarządzania energią, chłodzenia i wykorzystania odnawialnych źródeł energii.

Inne przeszkody

Zdaniem ankietowanych największą przeszkodą w rozwoju polskich centrów danych jest silna konkurencja ze strony globalnych graczy (średnia ocena: 4,05). Rozwój lokalnych dostawców cyfrowych usług utrudniają również wysokie koszty początkowej inwestycji związanej z koniecznością zakupu sprzętu i infrastruktury do jego obsługi (3,80), a także skomplikowane procesy prawno-administracyjne, w tym uzyskanie pozwoleń na budowę czy spełnienie regulacji środowiskowych (3,00). Jako mniej istotne bariery wskazano ograniczony dostęp do taniej energii i trudności w pozyskaniu lokalizacji.

Nowe priorytety: ESG i zgodność regulacyjna

Decyzje o modernizacji są coraz częściej determinowane nie tylko przez potrzeby techniczne, ale także przez standardy ESG oraz regulacje prawne. 80% operatorów wskazuje zmieniające się przepisy jako istotny czynnik wpływający na wybór nowych rozwiązań. Firmy zwracają też uwagę na aspekty odpowiedzialności ekologicznej, społecznej oraz jakości zarządzania, które wpływają na ich strategię inwestycyjną.

AI? Jeszcze nie teraz

Choć temat sztucznej inteligencji często gości w mediach, zainteresowanie AI w centrach danych jest na razie umiarkowane. 85% respondentów deklaruje, że mniej niż 10% ich infrastruktury IT wspiera AI. Tylko 15% badanych obsługuje AI w większym zakresie. Zastosowanie AI w polskich centrach danych wciąż pozostaje więc na wczesnym etapie rozwoju.

Dyski SSD dominują, ale HDD wciąż obecne

Na rynku pamięci masowej operatorzy centrów danych stosują zarówno HDD, jak i SSD. 60% firm deklaruje równy podział między tymi technologiami, a 30% stosuje głównie SSD, uzupełniając je o dyski talerzowe. Dyski SSD wykorzystywane są przede wszystkim do:

- Przetwarzania danych w czasie rzeczywistym (90% wskazań).

- Obsługi operacyjnej danych (80% wskazań).

- Zastosowań związanych ze sztuczną inteligencją i uczeniem maszynowym (50% wskazań).

W ocenie badanych kluczowe kryteria wyboru systemów pamięci masowej do obiektów data center to: kompatybilność z istniejącą infrastrukturą serwerową (średnia ocen 4,40/5), łatwość skalowania (4,30/5), wysoka wydajność operacji odczytu/zapisu (4,25/5) oraz duża pojemność (4,20/5).

Robert Sepeta, Business Development Manager w firmie Kingston, zauważa, że jeszcze przez dłuższy czas decyzja o wyborze pomiędzy mechanicznymi twardymi dyskami, a nośnikami SSD, będzie zależała od charakteru rozwiązania, któremu dostarczają dane lub z którego je zbierają.

– Twarde dyski przez najbliższe lata będą wykorzystywane tam, gdzie jest zapotrzebowanie na duże pojemności. Ale w rozwiązaniach w centrach danych, gdzie kluczowa jest wydajność, już od dłuższego czasu stosowane są głównie dyski SSD. Co więcej, widzimy, że operatorzy centrów danych wypracowali już korzystne dla siebie praktyki dotyczące taktyki nabywania nośników SSD. Gdy zdecydują się na określony produkt, trzymają się tego wyboru przez dłuższy czas, co najwyżej kupują dany model nośnika o większej pojemności. Bardzo ważna stała się dla nich wewnętrzna standaryzacja, a więc świadomość co do spójności oczekiwanego wsparcia posprzedażowego, możliwości łatwej wymiany i zagwarantowanych konkretnych parametrów technicznych. Istotne jest także bezpieczeństwo dostaw – operatorzy chcą mieć zagwarantowany bufor zapasowych dysków i pamięci, aby móc bez ryzyka rozbudowywać infrastrukturę, niezależnie od ewentualnych niedoborów rynkowych – mówi cytowany w komunikacie prasowym Robert Sepeta.

Kto decyduje o modernizacji?

Co ciekawe, w 50% przypadków decyzje dotyczące modernizacji podejmuje zarząd firmy, a jedynie 5% organizacji pozostawia je w rękach dyrektorów IT (CIO). Równocześnie, przy wyborze najlepszych rozwiązań operatorzy cenią sobie rekomendacje specjalistów IT (średnia ocen 3,6/5) oraz dostawców technologii i klientów (3,45/5).

Współpraca CFO (dyrektorów finansowych) i CIO (dyrektorów ds. technologii) staje się kluczowym czynnikiem sukcesu w cyfrowej transformacji firm. Jak pokazuje raport „KPMG 2025 CFO & CIO Collaboration Survey”, aż 92% liderów finansowych i technologicznych deklaruje partnerską relację, choć różnice w podejściu do inwestycji technologicznych wciąż stanowią wyzwanie. Eksperci KPMG wskazują, że integracja perspektyw CFO i CIO może zwiększyć efektywność inwestycji technologicznych oraz przyspieszyć skalowanie innowacji.

Wybór dostawcy

Przy wyborze nowego sprzętu cena nie jest czynnikiem decydującym – istotniejsze okazują się kompatybilność z istniejącą infrastrukturą, elastyczność dostaw oraz zgodność z normami energetycznymi.

Wybór dostawców sprzętu nie jest przypadkowy. 100% respondentów deklaruje współpracę z firmami globalnymi, o ugruntowanej pozycji. Zdecydowana większość (95%) korzysta też z usług różnych dostawców, w zależności od charakteru modernizacji. Co ciekawe, aż 90% firm chętnie współpracuje z polskimi dostawcami, jeśli spełniają oni odpowiednie kryteria. Cena nie jest najważniejszym czynnikiem – tylko 40% firm kieruje się nią w pierwszej kolejności. Istotniejsze okazują się: elastyczność, kompleksowe wsparcie techniczne oraz zgodność z normami energetycznymi.

Zasilanie i TCO

Poza modernizacją kluczowych komponentów infrastruktury, ponad połowa firm inwestuje także w nowe systemy zasilania awaryjnego – głównie w celu poprawy efektywności energetycznej. Technologie takie jak akumulatory litowo-jonowe mogą przyczynić się do lepszej efektywności energetycznej i zmniejszenia kosztów eksploatacji.

– Akumulatory litowo-jonowe są droższe niż kwasowo-ołowiowe, ale trwalsze i w dłuższej perspektywie bardziej opłacalne. Dodatkowo mogą być wykorzystywane do balansowania sieci elektrycznej, co przyczynia się do obniżenia kosztów użytkowania infrastruktury. Kolejnym ważnym aspektem jest sprawność wdrażanego UPS-a. Jeśli zasilacz wydziela zbyt dużo ciepła, to straty te mszczą się podwójnie. Po pierwsze, klient płaci za niepotrzebnie zużytą energię elektryczną, a po drugie musi ogrzane powietrze schłodzić za pomocą systemu klimatyzacyjnego, a to też kosztuje – ostrzega Paweł Poziemski z Vertiv.

Zarządzanie modernizacją centrów danych nie ogranicza się wyłącznie do technologii. Firmy coraz częściej korzystają z symulacji, analiz całkowitych kosztów użytkowania (TCO) i doradztwa technicznego partnerów, aby maksymalizować wydajność infrastruktury IT.

Badanie „Rynek centrów danych w Polsce” zostało zrealizowane w styczniu 2025 r. metodą CATI przez ośrodek Biostat na zlecenie firmy Kingston. Ankietą objęto dwudziestu decydentów IT z obiektów data center w Polsce.

(grafika tytułowa – źr. Kingston)

Pozostaw komentarz